(【4月25日 NHK】)

【ウクライナ ドローンにAI利用】

先ほど夕食をとりながらTVをチラ見していたら、NHKのクローズアップ現代でAIの軍事利用を取り上げていました。

****“AI兵器”が戦場に 第3の軍事革命・その先に何が****

AIの軍事利用が急速に進み、これまでの概念を覆す兵器が次々登場している。

実戦への導入も始まり、ロシアを相手に劣勢のウクライナは戦局打開のために国を挙げてAI兵器の開発を進める。イスラエルのガザ地区への攻撃でもAIシステムが利用され、民間人の犠牲者増加につながっている可能性も。

人間が関与せず攻撃まで遂行する“究極のAI兵器”の誕生も現実味を帯びている。戦場でいま何が?開発に歯止めはかけられるのか?【5月8日 NHK クローズアップ現代】

*******************

“第3の軍事革命”・・・第1が火薬、第2が核兵器、そして第3がAI

ウクライナのAI利用として取り上げていたのがドローンへのAI利用です。

ロシアに対し物量で劣るウクライナがその劣勢を幾分補うべく活用していたのがドローンですが、そのドローンもロシア側も大量に使用するようになっただけでなく、妨害電波で操縦不能になるという弱点も表面化しています。

そこでドローンにAIを組み込み、妨害電波にあっても自力で攻撃目標に到達・攻撃できるようにしているとのこと。

ウクライナが戦場で使用しているAIドローンとはややレベルが異なりますが、アメリカなどが開発しているAI自律飛行機は有人戦闘機と模擬空中戦を行えるほどに進歩しているようです。

****AI試験機とF16戦闘機が初の模擬戦 米空軍「飛躍的進歩」****

米空軍と国防高等研究計画局(DARPA)は、人工知能(AI)による自律飛行試験機が2023年9月にF16戦闘機との空中近接戦闘(ドッグファイト)の模擬戦を初めて実施したと発表した。

事故を起こさずに無事に模擬戦は終了。勝敗は明らかにされていないが、米軍は「良いパフォーマンスを見せ、航空宇宙分野の飛躍的進歩となった」と評価した。

米メディアによると、試験機はF16をベースに改良されたもので、性能を確かめたり、緊急時に操縦を代わったりするために2人が搭乗していた。有人のF16との1対1の模擬戦は2週間にわたって実施。試験機は最高時速1920キロで、垂直方向への飛行も行い、搭乗員に操縦を交代する場面もなかった。

米空軍は、F22ステルス戦闘機の後継機開発を含む「次世代航空優勢(NGAD)」計画を進めている。主力の有人戦闘機は、センサーやミサイル発射の機能を担う多数の無人戦闘機とネットワーク化して運用する構想を描いている。AI自律飛行機の試験成果も、無人機開発に生かされる見通しだ。【4月23日 毎日】

*********************

ドローンにAIを組み込んだものではなく、もともとの有人戦闘機をAIで自律飛行させるもののようです。それなら機体の飛行性能も有人戦闘機と変わりませんので、あとは人間とAIのどっちが操縦の腕が優れているかという話になります。

AIはベテラン操縦士の技量を数か月でマスターしたとか。状況分析・反応の早さ・能力については人間はAIに到底及ばないでしょう。

【「AIが2年で人間を超える」(イーロン・マスク氏)】

話が軍事利用からそれますが、以前から議論されているAIは人間の能力を超えるのか、それはいつなのかという議論について・・・・

****「AIが2年で人間を超える」 イーロン・マスク氏が予測****

米企業家のイーロン・マスク氏は8日、人工知能(AI)が2年以内には人間よりも賢くなるとの予測を述べた。X(旧ツイッター)の音声サービス「スペース」で行われたインタビューで答えた。

マスク氏は、最も賢い人間よりも賢いAIの登場は「恐らく来年か、2年以内だろう」と述べた。マスク氏はAIの危険性と規制の必要性を唱える一方で、自身も生成AIを開発する企業「x(エックス)AI」を立ち上げている。

AIを巡っては、開発に適している米エヌビディア製の半導体の争奪戦が企業間で生じている。【4月9日 共同】

*******************

訪中したマスク氏は“マスク氏はSNSでことし、AI開発に100億ドル、日本円でおよそ1兆5800億円を費やす方針であると明らかにしました。 自動運転技術などを念頭に置いているとみられ、マスク氏は「このレベルで支出できない企業は競争できない」と強調しています。”【4月29日 TBS NEWS DIG】

AIの“賢さ”の意味合いはよくわかりませんが、巨大企業が開発するAIが人間の能力を超え、やがて社会全般をコントロールする日も近いのかも・・・ターミネーターの世界の幕開けです。

【イスラエル ガザ攻撃での民間人犠牲者拡大の背景にAI利用の人物標的攻撃があるとの調査報告】

イスラエルのガザ攻撃では、ガザ保健当局発表で3万人を超える民間人犠牲者が出ているとのこと(2月29日時点)ですが、これほどの多大な民間人犠牲者が出ている一因にイスラエル軍によるAI利用があるとも指摘されています。

イスラエル軍はハマス戦闘員の特定、追尾・探索にAIを利用しているが、当該人物への攻撃は人間の判断でやっているとしています。

しかし、どういう情報をもとに戦闘員と特定するのか、人間の判断で攻撃というのは形式的なもので、実際にはAIの指示どおりに動いているだけではないのかという疑問、攻撃の際の民間人被害をどのように考慮しているのかという疑問などもあります。

AIが“標的”を探索特定してから人間がその者への攻撃を判断する時間的余裕は20秒とのことで、ゴム印を書類に次々に押すようにAI指示どおりの攻撃をしているのが実態であるとも。

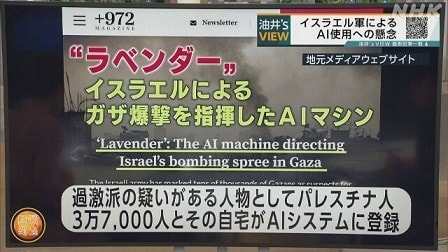

****ガザの3万7千人を標的化:AIマシーン「ラベンダー」の存在明らかに イスラエル独立メディアが調査報道****

イスラエルの独立系ネットメディア「+972マガジン」とローカル・コールは共同取材チームでイスラエル軍がガザ攻撃で使用している人工頭脳(AI)マシン「ラベンダー(Lavender)」についての長文の調査報道を公開した。(中略)

取材はイスラエル軍情報部門に属し、今回のガザ攻撃に参加し、ハマスやイスラム聖戦の工作員・戦闘員の暗殺作戦のために標的を生成するAIマシンの使用に直接関与していた6人の将兵にインタビューをし、情報源としているという。

■AIの指示を『あたかもそれが人間の決定のように』

情報関係者への取材に基づいて、記事では「ラベンダーは、特にガザ戦争初期段階において、前例のないパレスチナ爆撃で中心的な役割を果たしてきた。実際、情報源によると、軍事作戦に対するAIマシンの影響は、彼らは本質的にAI マシンの指示を『あたかもそれが人間の決定であるかのように 』処理した」と書いている。

ラベンダー・AIマシンは、ハマスとイスラム聖戦の軍事部門に所属している疑いのある、すべての工作員を潜在的な「人物標的」としてマークするように設計されている。調査報道に証言した4人の軍情報部兵士によると、「下位の工作員まで含む37000人を工作員リストとして標的にした」という。

私(川上)がガザの取材を通して知る限りでは、37000人を工作員リスト というのは、想像できない数字である。ハマスの戦闘員の名簿は公開されているわけではなく、戦闘員は自分が戦闘員であることを家族や隣人にも言っていないのが普通である。つまり、ラベンダー・マシーンがマークする「暗殺リスト」は、上級の幹部など既に知られたメンバー以外は、様々な情報を重ね合わせて推定されたものでしかない。

■ラベンダーを動かす軍情報部エリート部隊「8200」

この記事は、ラベンダーがどのように工作員の標的を生成するかについても書いている。ラベンダーを動かしている軍情報部のエリート情報部隊「8200」の司令官が、匿名で書いたAI関連の著作が紹介され、その中でラベンダーと同様の「標的生成」マシンを構築するための短いガイドが出ているという。

このガイドには、個々の人物の危険評価を行う「数百、数千の特徴」から、既に知られている戦闘員の通信ソフト「Whatsapp」のグループに入っているとか、数か月ごとに携帯電話を変更するとか、頻繁に住所を変更するなど、 いくつかの特徴を示している。

「視覚情報、携帯電話情報、ソーシャルメディア接続、戦場の情報、電話連絡先、写真」など特徴となる条件を人間が選び、AIマシンが与えられた膨大な住民データを特徴をもとに独自に分類する。

■AIで「ガザの住民を1 から 100 までの危険評価」

+972マガジン に証言した兵士は次のように語っている。

「ラベンダー・システムはガザのほぼすべての人物に 1 から 100 までの危険評価を与え、彼らが戦闘員である可能性がどれほど高いかを示している。ラベンダーは、訓練データとして機械に情報が供給された既知のハマスとイスラム聖戦の工作員の特徴を学習する。そして、これらの同じ特徴を一般の集団の中で見つけ、いくつかの特徴を持っていると判明された個人は高い危険評価に達し、自動的に殺害の潜在的な標的になる」

■イスラエル軍の230 万ガザ住民の大量監視システムが基に

このようなAI標的評価システムが機能するためには、対象となるガザ住民の包括的なデータが必要となるが、それはイスラエル軍が「230 万人のガザ住民のほとんどの情報を収集する大量監視システム」で集められた個人データが、ラベンダーシステムに入力されることになる。

つまり、既に確認されているハマスの工作員・戦闘員についての特徴が徹底的に分析され、その人物とSNSなどで連絡をとっている人々や、その人物と似た情報の特徴を持つ人々が、危険人物評価にかけられるということだ。

一見合理的に思えるかもしれないが、ハマスの工作員・戦闘員という認定は、推測でしかない。推定をいくら重ねても、ハマスの工作員・戦闘員を完全に割り出すことはできない。(後略)【4月9日 川上泰徳氏 YAHOO!ニュース】

*******************

230 万ガザ住民の大量監視システムをもとに様々な個人情報による推測・推定・・・当然“誤り”も生じます。

誤りの割合は10%とも。

****「10%の誤り」知りながらAI活用か ガザ、民間人被害が拡大 イスラエルのネット雑誌報じる****

イスラエルがパレスチナ自治区ガザで行ったイスラム原理主義組織ハマスへの攻撃で、「10%」の誤った標的を選定する恐れがある人工知能(AI)を活用したとの観測が出ている。ガザでは民間人の犠牲が急増し、米欧がイスラエルに標的を絞って精密攻撃を行うよう求めた経緯がある。(中略)

AIはハマスの奇襲を受けた昨年10月7日からの数週間で、住民3万7千人とその自宅を攻撃対象候補に選定した。うち数百件を無作為抽出して人間の手で確認したところ、90%はハマスと関係があったことが判明し、軍はAIに依存するようになったとしている。

証言によると、AIは対象人物が帰宅した時点で通知する仕組みで、同居する妻子らに多数の犠牲者が出た。国連は2月、ガザの死者の70%は女性と子供だと推計している。AIが帰宅を確認した標的が数時間後の爆撃時、別の場所に移っていたこともあった。

AIがハマス戦闘員と同じ氏名の人や、戦闘員が以前使った携帯を持っていた人を誤って攻撃対象候補に挙げた事例もあった。ある情報機関員は「(AIの対象選定は)現実と結びついていない」と証言した。

軍はハマス幹部1人を殺害するのに百人以上の民間人が犠牲になる攻撃も許可した。「幹部は病的な興奮状態」で「もっと標的(の情報)をよこせ」と要求したとの証言もあった。

軍は同誌に対し、AIは標的選定の「補助用具」に過ぎず、依存していないと主張した。(後略)【5月7日 産経】

***********************

【確認作業なしにAIが特定した者を「ゴム印押す」ように人間が実行、家族の家を爆撃する方がはるかに簡単、重要でない人物に対して高価な爆弾を無駄にしたくないから“愚かな”爆弾使用】

“誤り”を犯すのはAIでも人間でも同じです。 NHKクロ現では、イスラエルのAI開発関係者は、AIを使わなければもっと犠牲者は増加したはず・・・とも主張していました。

問題はAIシステムの運用の仕方にあったように思えます。

なぜAIの曖昧な推定をもとに、民間人犠牲が生じる攻撃がなされるようになったのか・・・以前は「上位の軍事工作員」だけが人物標的にされており、そのような危険人物については、攻撃時に家族など民間人犠牲が生じても止むを得ないという判断がありました。逆に言えば、軍事的に重要ではない「下位の工作員」を殺害するのに空爆することはできないという判断にもなります。

しかし、昨年10月7日以降、イスラエル軍は「ハマスでの階級や軍事的重要性に関係なく、軍事部門のすべての工作員を人物目標として指定することを決定した」とのこと。

標的の範囲がいきなり広がったために、以前は、一人の人物標的(「上位の軍事工作員」)の殺害を許可するために、軍情報部が行っていた確認のための作業ができなくなりました。

****AI使用した攻撃で、人間は「ゴム印押すだけの役割」****

取材源によると、以前の戦争では、一人の人物標的の殺害を許可するために、担当将校はその人物が確かにハマスの軍事部門の上位メンバーであったという証拠を照合し、彼がどこに住んでいたか、彼の連絡先情報を見つけ、最後には彼が家にいることをリアルタイムで確認する作業を行っていた。

しかし、今回のガザ攻撃の初期段階で、軍がラベンダー・システムが作成する殺害リストを採用することを承認したことで、「人間の職員はAIシステムの決定に対してゴム印を推すだけの役割を果たすことが多かった。通常、彼らは爆撃を許可する前にラベンダーのマークが付けられた標的が男性であることだけを確認して、一つの標的の確認に約 20 秒だけ使った」と情報関係者は証言した。

■標的を追跡し、帰宅を知らせる「父さんはどこ?」システム

さらに、イスラエル軍は標的となった人物が夜、家族全員と一緒にいるに時に攻撃するのが通例だったという。情報筋によると、「(軍事拠点を爆撃するよりも)家族の家を爆撃する方がはるかに簡単だからだ 」という。

さらに、標的が家に戻ったことを追跡する「父さんはどこ?(Where’s Daddy? ) 」と呼ばれるAI自動化システムが使用されたことも、今回の調査報道で初めて明らかになったという。

「父さんはどこ?」システムでは、ラベンダーによって標的とされた人物を継続的に監視下に置き、彼らが家に足を踏み入れたらアラートを出して知らせる。それによって、空爆が指令され、家を破壊する。

このシステムは、ラベンダーと組み合わせで、標的と一緒に家にいた家族全員が殺害する致命的な効果を上げたと、情報関係者は+972マガジンに語った。

■工作員一人の殺害に「10人の妻と子供」の巻き添え

このことについて、標的作戦室の士官は取材に対して、「例えば、ハマスの工作員一人に加えて、家の中の民間人10人を計算すれば、通常、それら 10人は女性と子供になる。ばかげているが、殺した人々のほとんどは女性と子供ということになる」と語った。

「父さんはどこ?」システムが夜、標的の人物が自宅に入ったとアラートが出ても、実際に空爆するのは未明になるなど、時間差があり、標的攻撃の直前に標的が実際にその場所にいるかどうかのリアルタイムの確認はないため、標的の人物は一時的に家に戻っただけで、その後、家を出て、空爆して死んだのは妻と子供だったり、または夜中に家族全員が別の家に移ったために、空爆して死んだのは、何も知らない周辺住民家族だけだったという例も実際にあったとしている。

■下位の戦闘員の標的は無誘導の“愚かな” 爆弾使用

さらに悪いことに、ラベンダーがマークした下位の戦闘員とされる人物を標的にする時には、軍は無誘導ミサイルを使用することを求めたという。

一般に無誘導ミサイル は衛星で誘導されピンポイントで標的を攻撃できる“賢い” 精密爆弾とは対照的に “愚かな” 爆弾として知られている。そのために、居住者が住む建物全体が破壊され、多くの死傷者が発生する可能性があった。

+972マガジンの取材に応じた情報将校は「重要でない人物に対して高価な爆弾を無駄にしたくない。それは国家にとって非常に高価であり、精密爆弾は不足している」 と述べた。

別の情報関係者は、自らラベンダーがマークした若手工作員とされる数百の個人の家を爆撃することを許可したと述べた。それらの攻撃の多くは民間人と家族全員を殺害し、「巻き添え被害」となった。【前出 YAHOO!ニュース】

*********************

確認作業なしにAIが特定した者を「ゴム印押す」ように人間が実行、家族の家を爆撃する方がはるかに簡単、重要でない人物に対して高価な爆弾を無駄にしたくないから“愚かな” 爆弾使用・・・なんともやりきれない戦争の実態です。民間人犠牲が膨らむのも当然でしょう。

****「10%誤り」認識なら人道法違反の可能性 防衛大学校・黒崎将広教授(国際法)****

報道が事実であれば、10%は間違える可能性があることを知りながらAIを使用したことになり、ジュネーブ諸条約や追加議定書などで構成される国際人道法に違反した可能性がある。

標的の評価を間違えて攻撃した場合、民間施設や民間人と区別して軍事目標を攻撃するよう定めた「区別原則」違反に問われる。

結果的に正しい標的を攻撃した場合でも、10%誤る可能性を防ぐ措置を取っていなければ、民間施設や民間人への誤った攻撃を防ぐ義務があると定めた「予防原則」違反となり得る。

イスラエルは追加議定書には不参加だが、この2つの原則は慣習法として順守する立場をとっている。

ハマスの司令官を攻撃する際、多数の民間人が巻き添えになってもよいとの命令をイスラエル軍が下していたとしても、ただちに違反にはならないが、標的を10%間違える可能性があると知っていて攻撃したのなら無視できない。

特に、敵対行為に直接参加していない民間人などの非軍事目標を直接攻撃する可能性を知っていたのであれば、故意の区別原則違反となり戦争犯罪に該当し、国際刑事裁判所(ICC)の訴追対象になると思う。

AIの軍事利用については規制の議論が進んでいる。人間の指揮命令系統の下で運用し、責任の所在を明確にすることが目的だ。米国が主導して作成された政治宣言には日本など50を超える国・地域が支持表明している。

昨年11月には米ニューヨークでこの宣言に関する初会合が開かれており、イスラエルとハマスの戦闘がAI規制の機運を醸成したことは間違いない。(談)【5月7日 産経】

********************

AIの軍事利用でも、もっとも議論になるのはAIが独自の判断で人間を殺す・・・自律型兵器システム(AIを使って人間の関与なしに敵を攻撃する兵器システム)ですが、アメリカ、ロシア、中国といった軍事大国の思惑もあって規制の議論が進みません。 そのあたりの話は長くなるので、また別機会に。