最短路問題のプログラムを用いて実験を行ったが、プログラムの方は変更せずにクエリファイルだけを少しだけ加工してみた。

○計算サーバ

CPU : AMD Opteron 8439 (2.80GHz / 6MB L3) x 4

Memory : 128GB (32 x 4GB / 800MHz)

gcc : 4.4.2

OS : Fedora 12 for x86_64

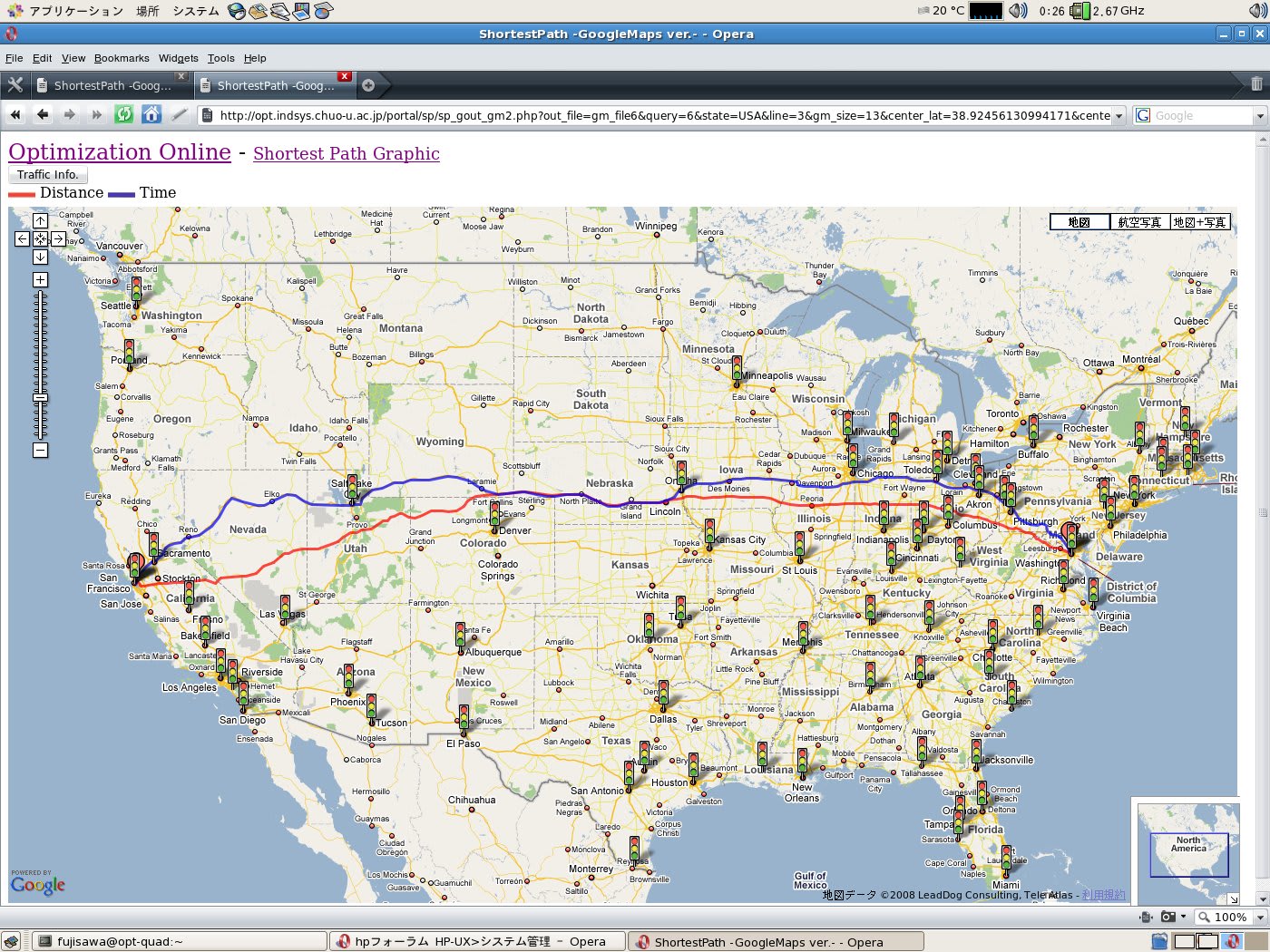

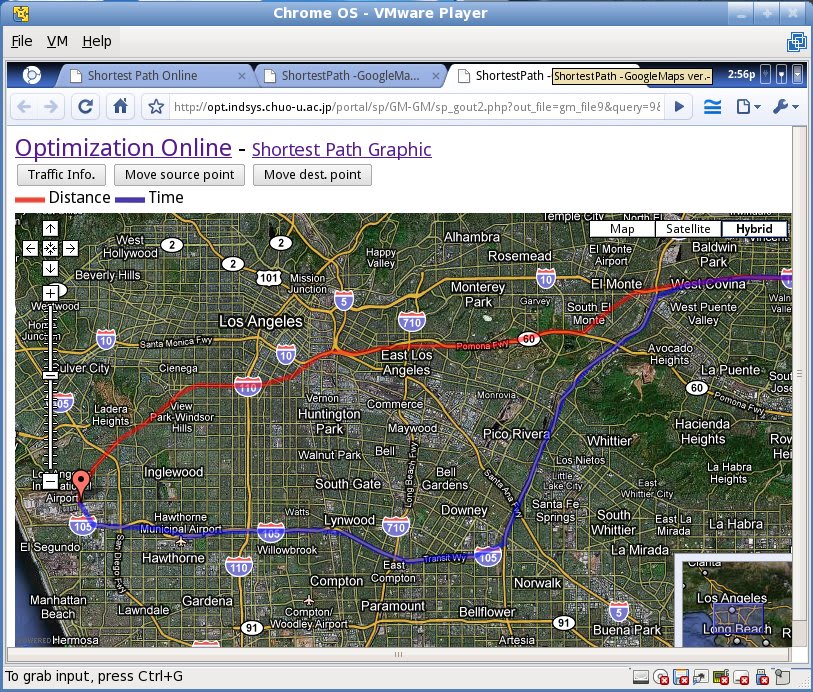

HT Assist を ON にした方が良さそうだが、リモートでは変更できないので、OFF のまま使うことにする。また使用する問題は以下の CTR でクエリ数は1000とする。

http://opt.indsys.chuo-u.ac.jp/portal/sp/G-G/sp_graphic.php?state=CTR

1: time numactl -i all --physcpubind=0,1,2,3,4,5,6,7,8,9,10,11 ./spp-solve ../../mmap/CTR-d.m-gr ../../query/CTR1000.p2p

real 5m22.781s

2: time numactl -i all --physcpubind=0,1,2,3,4,5,6,7,8,9,10,11 ./spp-solve ../../mmap/CTR-d.m-gr ../../query/CTR1000-1.p2p

real 5m22.099s

3: time numactl -i all --physcpubind=0,1,2,3,4,5,6,7,8,9,10,11 ./spp-solve ../../mmap/CTR-d.m-gr ../../query/CTR1000-2.p2p

real 5m21.466s

性能向上は少しだけではあるが、クエリファイルの処理方法によって改善の余地がまだまだありそうだ。

○計算サーバ

CPU : AMD Opteron 8439 (2.80GHz / 6MB L3) x 4

Memory : 128GB (32 x 4GB / 800MHz)

gcc : 4.4.2

OS : Fedora 12 for x86_64

HT Assist を ON にした方が良さそうだが、リモートでは変更できないので、OFF のまま使うことにする。また使用する問題は以下の CTR でクエリ数は1000とする。

http://opt.indsys.chuo-u.ac.jp/portal/sp/G-G/sp_graphic.php?state=CTR

1: time numactl -i all --physcpubind=0,1,2,3,4,5,6,7,8,9,10,11 ./spp-solve ../../mmap/CTR-d.m-gr ../../query/CTR1000.p2p

real 5m22.781s

2: time numactl -i all --physcpubind=0,1,2,3,4,5,6,7,8,9,10,11 ./spp-solve ../../mmap/CTR-d.m-gr ../../query/CTR1000-1.p2p

real 5m22.099s

3: time numactl -i all --physcpubind=0,1,2,3,4,5,6,7,8,9,10,11 ./spp-solve ../../mmap/CTR-d.m-gr ../../query/CTR1000-2.p2p

real 5m21.466s

性能向上は少しだけではあるが、クエリファイルの処理方法によって改善の余地がまだまだありそうだ。