私は、図書館で酒井邦嘉の『言語の脳科学』(中公新書)を見つけ、タイトルがとても興味深いので、それを借りてきた。副題は「脳はどのように言葉を生み出すか」である。

しかし、中身はちょっとガッカリするものだった。これまでの言語学や他の学派を誹謗中傷するだけで、紹介されている知識や仮説は目新しいものがなかった。2000年発行だから、新規性は致し方がないにしても、その攻撃性にはうんざりする。

彼の書の第8章で、1997年にIBMの開発したチェス・コンピューター「ディーブ・ブルー」がチェス世界チャンピオンに勝った話が紹介されている。彼は言う。

「それでは、これで人間の思考の一端が解明されたかというと、それは正しくない。チェス・コンピューターは、一手ずつしらみつぶしに先読みをして、それぞれの損得を評価し、もっともよい手を選んでいるので、人間の直観や大局観に基づく思考とは根本的に違う。」

当時、IBMの研究所の末席にいた私としては、これに異議申し立てをしたい。チェスにかぎらず、コンピューターに対戦ゲームをさせることが大学や研究所で流行っていた。その当時の共通認識として、「一手ずつしらみつぶしに先読み」では、コンピューター資源が莫大に要求されるから、人間の直観や大局観をどう取り入れて、先読みする手を数を減らすかが、勝つための要(かなめ)と見なされていた。コンピューターが過去の勝負の譜面を学習し統計的に形勢判断を下すことである。

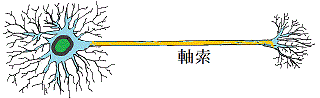

それまでの特定の確率モデルを仮定した統計的判断は、確率変数が増えるにつれて、判断が不安定になる。統計的判断にIBMが採用したのは動物の大脳皮質を模倣したニューラルネットワークである。のちにディープラーニングと呼ばれるものは、統計的に最善のニューラルネットワークを膨大な学習データから構成する数学的アルゴリズムで、このアルゴリズム自体には、人間の脳との対応関係はない。

酒井は、彼の書で、言語の本質を文法として捉え、チョムスキーを「知の巨人」として神のように讃えている。

彼は、また、チョムスキーに批判的な田中克彦を第4章で批判しているが、田中の『チョムスキー』(岩波新書)を読んだ私としては田中のチョムスキー理解のほうを支持する。田中は、チョムスキーが、言語を表層として、その深層に精神(マインド)があるとした、という。

私も、人間集団の中でコミュニケーションを成立させるために、時間をかけて、歴史的に言語を各集団は発達させてきたと考える。すなわち、言語の前に伝えたい概念があると考える。その概念に集団間で類似性があるために、言語に、形態が異なったも、機能に類似性が生じる。しかし、ばらばらに発生した言語は、集団生活の違いのため、機能の面でも相違点がある。

私は、発話が困難の子どもから多弁な子どもまでの療育に携わったことや、英語だけでなく古典ギリシア語やドイツ語を学んだことから、そういう見解に至っている。

坂井はチョムスキーの言語の生得性や生成文法にこだわる。1990年代に、私のいた研究所で、音声認識、音声合成、機械翻訳の研究が盛んであった。規則に基づく認識、合成、翻訳のアプローチはことごとく失敗した。現在、成功しているのは、膨大なデータから音素や単語の作る構造を統計的に学習するアプローチである。

言語の生得性とは、あくまで、脳のニューロンのネットワークが可塑性と豊かさの保証であり、その条件が満たされば、学習の問題であると私は考える。