「深層学習の父」といわれるヒントン教授の動画があるんだけど↓

【ヒントン教授】人知超すAIは人を操る 「ゴッドファーザー」が語る脅威【トロント大】

これって、ヒントン教授の釣り?

ってか、ディープステートやGoogleに対する批判?

ヒントン教授が研究し、今人気の機械学習(生成AIなんかもこれ)は、

与えられたデータを学習して、その学習結果に基づいて動作する。

だから、人間がAIに操られているように見せかけて、

実はAIに学習データを与えた人に操られている。

これはAIにちょっとでもかかわった人ならわかるはず。

だから、「AIは人を操る」ってヒントン教授が考えているのは、

違和感あるなあと思って見るのを進めると・・・

「地球温暖化を止めるには」をAIに尋ねたら

「人口削減すればいい」と答えるかも・・・

で、気づきますね!

そう、そうなんですよね。

・AIはディープステートが自分たちに都合のいいように機械学習させて、

・一般の人には「AIは人を操る」って吹聴して

・自分たちがAIを使って人々を支配しているっていうことを見えなくさせる

AIは、そんな道具ですよね。

さすが、ヒントン教授!そのとおりです。機械学習の本質突いています!

AIはディープステートが自分たちに都合のいいように利用するに違いない。

間違いない

そして、ヒントン教授がGoogleを退職する理由は

自由に発言するため・・・

たしかに、たしかにそのとおりですね!

AIはディープステートが自分たちに都合のいいように利用するに違いない。

なんて、Googleの社員だったら絶対言えません。

Googleは広告業で、広告業である限り、お客さんであるディープステートの不都合な話は言えません。

自由に発言するには、Googleやめないといけません。

なるほど~

・・・っていう理解でOK?この動画??

まじか・・・

あの写真、肌色のきれいさを確認するにはいい画像だと思うんだけど

著作権・肖像権の問題ではなく、女性を性的対象化してい るという理由かららしい・・・

なんか、絵を入れたいとき、フリー素材の「いらすとや」さん

をよく使うと思うけど、あの「いらすとや」さんの絵を、

最近はやりの生成AIを使って作ってくれるサービス

「AIいらすとや」さん

っていうのが、

情報処理 2024年4月号で紹介されていたし、

YouTubeの広告でもよく出てくるので、

今回無茶振りしてみた

■使い方

まず、

にいく。

そうすると、↓のような画面が出てくる

「AI画像生成」の下に、入力欄がある(「着物を着たうさぎ、正面を見ている」と書いてあるが、そこになんか文字が入れられる)

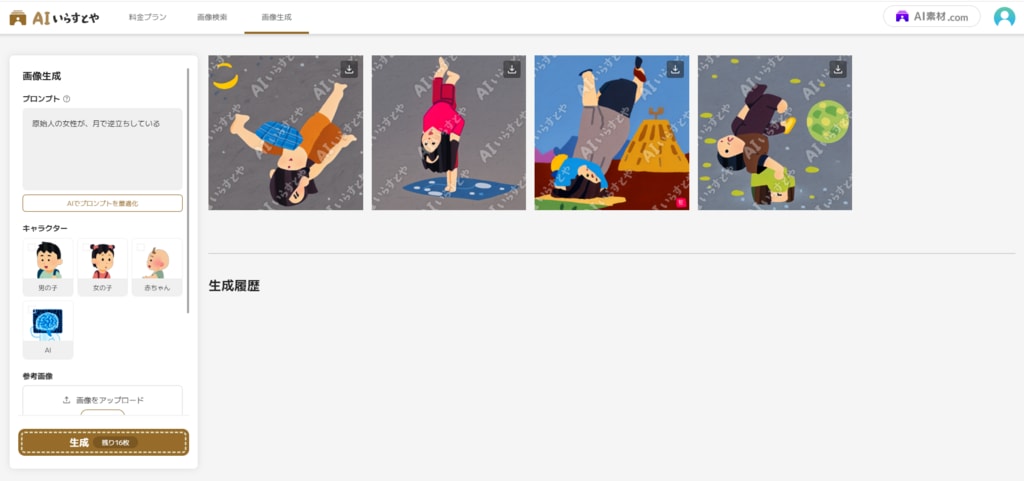

今回は

「原始人の女性が、月で逆立ちしている」

と、そこに入力して、無茶振り画像を生成させてみましょう。

「生成画面へ」ボタンをクリック

すると、以下の画面が出る

真ん中のボタンをクリックして、Googleアカウントでログインする

・・・と、結局画面は変わらない。

入力はされているので、もう一回「生成画面へ」をクリック

すると、以下の画面になる

「生成(残り20枚)」ボタンをクリックすると・・・

こんな感じで生成される・・・無茶振り過ぎましたね(^^;)

無料だと、月20枚しかせいせいできない。

みなさんは、こんなおバカなものを振って、フリーの枠を無駄に使わないように・・・

ちなみに、同じプロンプト「原始人の女性が、月で逆立ちしている」を入れて、画像生成AIサービスのSeaArtで生成させると、こんなかんじになる

うん、SeaArtでこれだから・・・やっぱ、無茶振り過ぎましたね

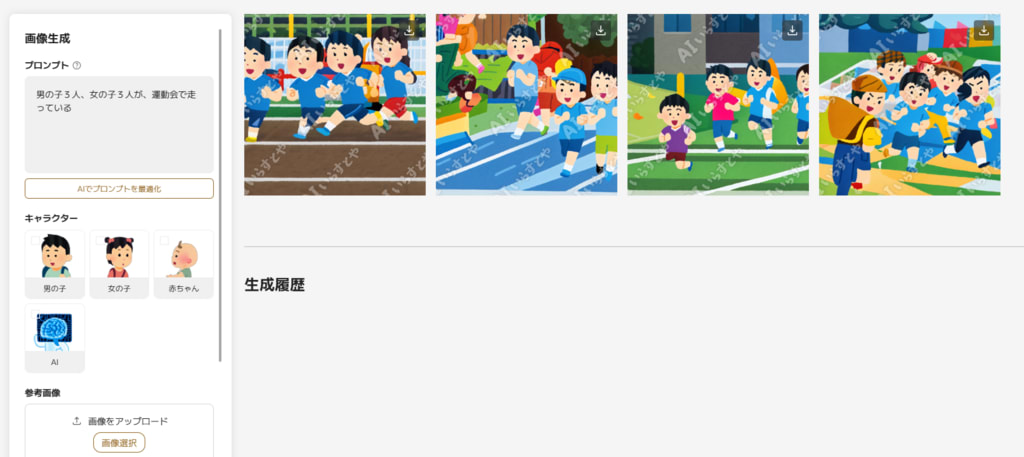

ちなみに、AIいらすとやさんに、「男の子3人、女の子3人が、運動会で走っている」って入れて生成させると、↓な感じで、いい感じに生成される

はじめの図をダウンロード

人数は違うけど、いい感じですね(^^)v

最後の図をダウンロード

左端の人、意味不明・・・

今の生成AIって、まあ、こんなもんなんですかね(^^)v

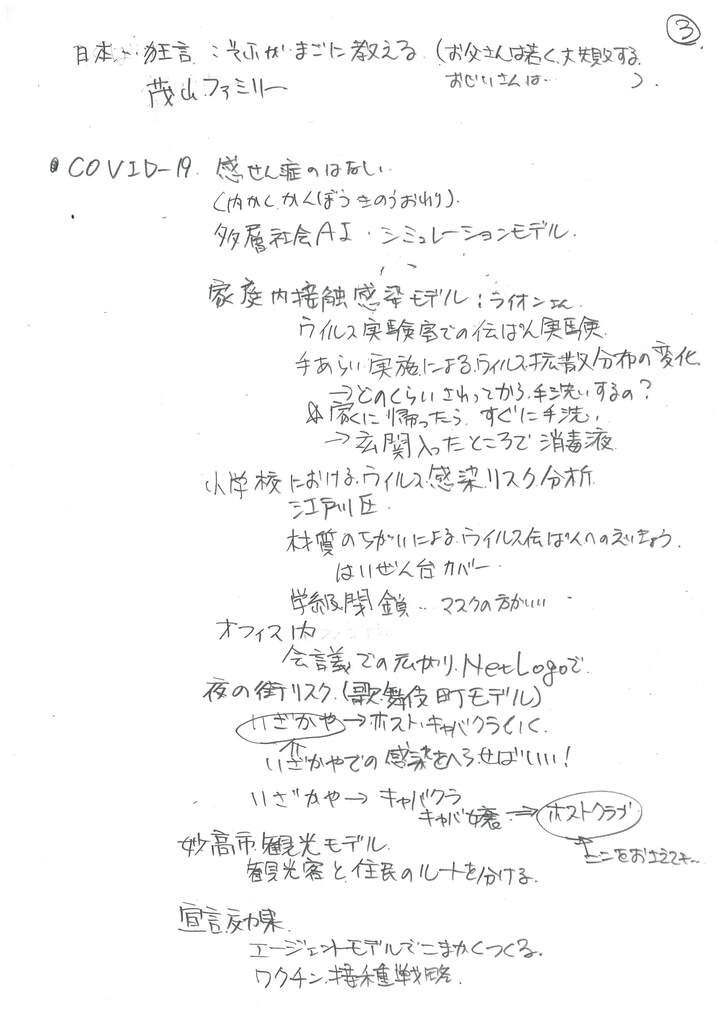

コロナがはやったとき、初めの予測モデルは、

8割おじさんの西浦先生が話題だったけど、

パンデミックが広まって後は、どのように行動したらよいか

のシミュレーションが取り上げられることが多かった。

で、そのシミュレーションが出たしたとき、NHKなんかで

筑波大学の倉橋先生が出て来たけど、

3月23日に筑波大学東京キャンパス(茗荷谷)で、

倉橋先生の最終講義があったので、物見遊山で聴いてきた!

あの感染症研究は、放送大学の面接授業がら着想を得たそうで

そのほか、放送大学いいよって話と

(倉橋先生は放送大学卒→筑波大大学院卒)

どういう研究してきたかと、

代表的な研究の、科挙の合格者の出る家系の研究、

コロナ時におけるシミュレーションとかの話をしてくださいました

とくに、コロナ時、ホストクラブが規制されたけど、

ホストを規制しても意味ない、なぜなら、ホストは客のキャバ嬢から感染し、

キャバ嬢は、出勤するとき、同伴のおじさんと、居酒屋で待ち合わせする。

コロナはその居酒屋で起こるから、居酒屋たいさくしないと・・

という、コロナにおけるホストの感染モデル(歌舞伎町モデル)

も説明してくださいました。

以下、その講義内容のメモ。大きく空白が開いているところは、

書ききれなかったところ

このあと、記念写真だったみたいだけど、

さすがに関係ない自分が記念写真に入ったらおかしいので、

ここらで、帰ってしまいました。

なので、そのあとのことは知らん。。

↓のリンク先の記事

ただ、こういうのを規制するのは難しいと思うよ。

確かにアプリは規制できるけど、

既存の着衣の写真を脱がすだけなら、一般に使われる画像生成AIのStable Diffusionでもできるし、さらにもっと簡単お手軽にSeaArtでできてしまうから。

ただ、簡単にできる割にはそこまで広まっていないのは、

「お手軽に」作るには簡単だけど、

「きれいに、思った通りに」作るには、かなり難しいからだろうね・・・

・・・首のところがきれいにつながらないんだよね・・・

コントロールネットとか使えば、うまく行くのかもしれないけど、

そこまでやるには、ある程度の技術習得が必要なわけで・・・

とはいえ、そういう技術を持っている人もいるから、

大々的には広まんなかったとしても、

規制をして撲滅させるのは、難しいんじゃないかなあ?

ロボットや産業用の機械は現在、PLC(シーケンサー)やIPC(産業用PC)で制御するけど、このPLCをChatGPTで制御できるっていう話が、↓の動画

(4分2秒のところIntegration of ChatGPT into TwinCATの話)

三菱がやらねば誰がやる?欧州の製造業最前線から…製造業立国「日本」が生き残る道を探る

にでてるんだけど、たぶん、これのこと?

この記事見ると(英語なので読み間違えてるかもしれないけど)、

うまい具合にはぐらかしている(そうは書いていない)ようにも読める。

TwinCAT XAEはチャットクライアントで、ChatGPTと接続することができて(ここまでは書いてある)

The TwinCAT Chat Client enables AI-supported engineering to automate tasks

AIが支援する自動化のためのエンジニアリングを可能にする

このあと、自動化の例としてSuch asで、PLC生成みたいなことが書いてあるんだけど、これは、ChatGPTがPLC生成出来れば、それを支援するよ!というだけで、(実際まだChatGPTはできないのでは?)今の段階ではできない、受け口だけあるよっていうようにも読めるんだけど・・・

自分の英語力が低いからかな(^^;)ちょっとわからん・・・

ロシアの大統領プーチンさんも生成AIについて発言しているみたい

たしかに、グローバルマイノリティ(西側諸国のことを、最近こういうんだって)だけで、ChatGPTだけで生成AIを規制している感じだよね~

金儲けのために規制作って排除するっていうのは、オープンソースの精神からしてどうなの??

ロシアやの文化を尊重しているとも、言い難いよね・・

それに今、実用レベルで言ったらChatGPTより画僧生成AIのほうが(Stable Diffusionとか)のほうが、進んでるもんねえ・・・

といったら、画像生成AIでも話題が・・・

生成AIを語って

これ、児童ポルノに生成AIを含めるなら、規制できると思うけど、

生成AIを規制することはできないと思うよ・・・

いや、今の時点では生成AIかどうかを判定するソフトはあるけど

それは今規制されていないからで、

規制されたら、今度はAIと指摘されないような画像を生成するように

学習するだけだと思う。

生成AIは規制しても、規制をくぐる方法を学習すればいいだけの話で

いたちごっこなんだよね・・・

以前、Stable DiffusionのCLIPの説明について書いたところ、

結構見てくれる人が多かったので、

今回は、もう一つの重要技術 Diffusion Model(拡散モデル)について説明してみる。

拡散モデルの説明例として↓の動画がある

【5分で分かる】画像生成AIで頻出の拡散モデルについて分かりやすく解説!

↑の記事では、拡散モデルについて

「ある画像に対してランダムノイズを徐々に当てていき、完全にノイズになったものを逆向きに推定した際に、ノイズ除去後の画像と元の画像の差分を少なくするように学習した技術」

としていて、これ、拡散モデルを知っている人や、機械学習でモザイクを外す方法とかを知っている人には、そのとおりの話だし、すぐに分かるけど、知らない人には、まったく意味不明だとおもうので、ちょっと説明。

としていて、これ、拡散モデルを知っている人や、機械学習でモザイクを外す方法とかを知っている人には、そのとおりの話だし、すぐに分かるけど、知らない人には、まったく意味不明だとおもうので、ちょっと説明。

この技術、機械学習でモザイクを外す技術と比較すると、すごく考えやすい。

に端折って書いてあるけど、後で拡散モデルと比較できるように、もうちょっと丁寧に書くと、

(1)学習データの作成

1-1 モザイクのかかっていない元画像を用意する。

1-2 この画像に対して、

5%モザイクがかかったもの(モザイクかかってるけどまだわかる)、

10%モザイクがかかったもの(だんだんわかんなくなる)

10%モザイクがかかったもの(だんだんわかんなくなる)

:

100%モザイクがかかったもの(まったくわからん。モザイクで)

という、モザイクの程度(かかり具合)を変えた画像を数段階用意する

(2)学習

2-1 上記1ー2で作成した画像は、

5%→10%→20%→・・・→100%と、

だんだん、モザイクが強くなっていってるけど、

これを逆に学習する。

つまり、はじめ、

100%モザイクがかかっている画像を入力

90%モザイクがかかっている画像を出力

を学習させ、次に

90%モザイクがかかっている画像を入力

80%モザイクがかかっている画像を出力

という風に順々に学習させていくと、

:

最後、

5%モザイクがかかっている画像を入力

元の画像を出力

っていう風になる。

(3).機械学習によるモザイク外し(推定)

ここで、モザイクがかかった画像、

例えば30%モザイクがかかった画像を入力すると、

(2)の学習により、

20%モザイクがかかった画像が返ってくる。

そこで、その20%モザイクがかかった画像を入力として入れると、

10%モザイクがかかった画像が返ってくる

さらに、10%モザイクがかかった画像を入力すると

5%モザイクがかかった画像が返ってきて

5%モザイクがかかった画像を入力すると

元のモザイクがない画像が返ってくる

このように、モザイクがかかっている画像を入力し、推論させ

出力して出て来た画像を、再度入力として推論させるということを

何回か繰り返すと、いつかは、モザイクのかかっていない元の画像を

返すことになる。

ってことになる。これが、AIによるモザイクの外し方。

拡散モデルは、モザイクではなく、これを、ノイズで行う。

つまりこんな感じ(上のモザイクと比較してね)

(1)学習データの作成

1-1 ノイズのかかっていない元画像を用意する。

1-2 この画像に対して、

5%ノイズがかかったもの(ノイズかかってるけどまだわかる)、

10%ノイズがかかったもの(だんだんわかんなくなる)

10%ノイズがかかったもの(だんだんわかんなくなる)

:

100%ノイズがかかったもの(まったくわからん。ノイズで)

という、ノイズの程度(かかり具合)を変えた画像を数段階用意する

(2)学習

2-1 上記1ー2で作成した画像は、

5%→10%→20%→・・・→100%と、

だんだん、ノイズが強くなっていってるけど、

これを逆に学習する。

つまり、はじめ、

100%ノイズがかかっている画像を入力

90%ノイズがかかっている画像を出力

を学習させ、次に

90%ノイズがかかっている画像を入力

80%ノイズがかかっている画像を出力

という風に順々に学習させていくと、

:

最後、

5%ノイズがかかっている画像を入力

元の画像を出力

っていう風になる。

(3).機械学習によるノイズ外し(推定)

ここで、ノイズがかかった画像、

例えば30%ノイズがかかった画像を入力すると、

(2)の学習により、

20%ノイズがかかった画像が返ってくる。

そこで、その20%ノイズがかかった画像を入力として入れると、

10%ノイズがかかった画像が返ってくる

さらに、10%ノイズがかかった画像を入力すると

5%ノイズがかかった画像が返ってきて

5%ノイズがかかった画像を入力すると

元のノイズがない画像が返ってくる

という形になるけど、今、30%からはじめたけど、

これ、100%から始めてもいいよね。同じ理屈でできる

・・・

けど、冷静に考えてね。100%ノイズって、ただのノイズだよ。

つまり、ノイズから画像を生成していることになる。

これが拡散モデル。

動画に出てくる説明と↑の説明を対比すると、

「ある画像に対してランダムノイズを徐々に当てていき、

が、(1)学習のところに対応

完全にノイズになったものを逆向きに推定した際に、

が「(3).機械学習によるノイズ外し(推定)」の

「100%から始めてもいいよね。」の話

ノイズ除去後の画像と元の画像の差分を少なくするように学習した技術」

この学習が「(2)学習」の学習の話。

Stable Diffusionでは、この学習部分をUNETというもので実現している。

でも、ここでモザイク外しとStable Diffusionで決定的な違いがある。

上記モザイク外しでは、白人の画像で学習し、白人のモザイク画像を入力したとき、黒人のモザイク外し画像を出力することはできないが、

Stable Diffusionではできている。

これは何故できるのかというと、Stable Diffusionでは、画像を直接扱うのではなく、潜在変数と呼ばれる、抽象化した概念の変数を使う。これにより、文字と画像を合わせることが可能になる。

Word2Vecの話で、分散表現というのが出てくる。文字列は

One-hotベクトルという、単語の出現回数をベクトルにしたもので表現できるけれど、それだと、同じ意味の言葉でも、言葉が違えば、違うベクトルとなってしまう。言葉を概念で表せば、同じ意味の言葉を同じベクトルであらわすことも可能になってくる。この概念等、One-hotベクトルを集約して表す方法が分散表現。

そして、文字列の分散表現と画像の分散表現(ここでは潜在変数と言っている)を使って学習させると、上記のような白人の画像入力して、黒人の画像を出力することができるんだけど、その話は長くなるので、別の機会にしたいと思います。そのとき、Stable Diffusionの全体像を示す・・・って、今リンクしちゃってもいいか。↓に置いておくね

上記画像は より引用(なぜか、リンク先をイメージにしないとエラーが出た)

より引用(なぜか、リンク先をイメージにしないとエラーが出た)

より引用(なぜか、リンク先をイメージにしないとエラーが出た)

より引用(なぜか、リンク先をイメージにしないとエラーが出た)Stable Diffusionなどの、画像生成AIで、テキスト文字から画像を生成するときに、テキストと画像を紐づけるCLIPという技術を使う↓

まあ、CLIPを意識して使うのは、呪文(プロンプト)をどのくらい反映させるかというCLIP skip指定のときだと思うけど

(↓はCLIP Skipのレベルを変えるとどうなるか、画像で説明してる)

このCLIPについて、説明している動画があったのでメモ

CLIPのアプローチ

幾田りらさん(YOASOBIのikuraさん)が歌ったら・・・っていうAIカバーが出てるけど・・・↓

確かにめちゃくちゃ似ててすごいけど、

本人が歌ったほうが、もっとうまい気がする・・・

ぜひぜひ、本人が歌ってみてほしい・・・

・・・はいいんだけど、どうやって作るんだろう?

そういうソフト(歌を入力すると、ikuraさんのAIカバーが出てくる)があるんだろうか?検索しても、見つからなかった・・・

たしかに、ikuraさんの歌を用意すれば、それを学習して、そのあとに、歌を入力すれば、AIカバーが出てくるAIカバーツールは、↓のようにあるみたい…

こういうので、作ったのかなあ~

たしかに、ikuraさんの歌なら、いろいろ用意できそうですもんね・・・

チコちゃんに叱られる!の6月23日分の2つめの疑問(開始12分ごろ~)の「頭がいいって何」見た?

まさに、ChatGPTが、どうして人間みたいに見えるのか、

でも、どこに限界があって、どうして漫才がおもしろくないのか

が、一発で分かる内容でしたね!

まさに、ChatGPTが、どうして人間みたいに見えるのか、

でも、どこに限界があって、どうして漫才がおもしろくないのか

が、一発で分かる内容でしたね!

その「チコちゃんに叱られる」では

立命館大学 総合心理学部教授の

サトウ タツヤ先生

(このブログでは、基本的に学校で教えてる人の敬称を先生にしています)

が、「頭がいいとは」について説明してたんだけど、

まず、よく、頭のよさを表すのにIQが使われますが、

(あとで述べられますが、先生はこの考えに否定的)

IQは3つのことを問われるそうだ

・流動性推理(隠された法則を推理し、先を読む力)

・ワーキングメモリ

・言語理解

ここからはチコちゃんではやってなかったけど、

IQは3つのことを問われるそうだ

・流動性推理(隠された法則を推理し、先を読む力)

・ワーキングメモリ

・言語理解

ここからはチコちゃんではやってなかったけど、

ChatGPTの場合、

・言語理解は、大規模言語モデル(LLM)で学習している

・ワーキングメモリは、メモリを増やせば対応できる

けど、

・流動的推論

・ワーキングメモリは、メモリを増やせば対応できる

けど、

・流動的推論

については、ChatGPTと人間で大きな差がある。

流動的推論について、まず、推論の仕方は2つある

・類似を基に、たくさんの事象から物事を推論していく(帰納的)

・論理的に判断していく(演繹的)

人間は、両方できる。

・論理的に判断していく(演繹的)

人間は、両方できる。

ChatGPTは・・・

アテンションという処理機能をつかうので、

(このアテンションは、基本類似がベースなので)

帰納的な考えでほぼきまってしまう。

アテンションという処理機能をつかうので、

(このアテンションは、基本類似がベースなので)

帰納的な考えでほぼきまってしまう。

なので、人間のように演繹を使って考える計算や論理が苦手となる。

(ステップバイステップは論理的に考えろという指示になっているので、

これを入れると論理的な判断を少しして、人間に近づいて計算できる)

この「類似にプラスして論理的思考ができるか」どうかというところが

ChatGPTと人間との差であると。

(ステップバイステップは論理的に考えろという指示になっているので、

これを入れると論理的な判断を少しして、人間に近づいて計算できる)

この「類似にプラスして論理的思考ができるか」どうかというところが

ChatGPTと人間との差であると。

なお、ChatGPTがフェイクを発生してしまうのも、この理由で説明つく。

帰納が進むと、アブダクションという考え方を生み出してしまい、

このアブダクションは誤謬も生み出してしまう。

フェイクはこのアブダクションの誤謬からくる。

人間の場合は、論理的にも考えるので、論理性のほうから、この

誤謬を否定できるんだね!

ちなみに、ChatGPTに漫才をさせたら全く受けなかったのは、

(これはチコちゃんの番組ではなく、たしかマツコさんの番組だけど)

ギャグ(特に漫才)は

・類推で考えたら、それが成り立つけど

・論理的に考えたら違う(ないしは意外にもなりたつ)という事柄で

・みんなが気付く前に、相方・ないしは自分がツッコんで、明確にする

ことにより、発生するものだと思うのですが、

・類推で考えたら、それが成り立つけど

・論理的に考えたら違う(ないしは意外にもなりたつ)という事柄で

・みんなが気付く前に、相方・ないしは自分がツッコんで、明確にする

ことにより、発生するものだと思うのですが、

ChatGPTは類推で考えたら成り立つことは言えても、

論理的に考えられないので、

論理的に成り立たないかどうかはわからない。

論理的に成り立たないかどうかはわからない。

そこで、ギャグが成立する、

「類推では成り立つが、論理では成り立たないすれすれのところ」

がわからず、この状態でギャグを作らせると、

推論で成り立つ適当なことをいろいろ言うので、

当たる可能性もあるけど、滑る可能性のほうが高くなり、面白くない。

おお、これに気づかせる「チコちゃんに𠮟られる」すごい!

推論で成り立つ適当なことをいろいろ言うので、

当たる可能性もあるけど、滑る可能性のほうが高くなり、面白くない。

おお、これに気づかせる「チコちゃんに𠮟られる」すごい!

チコちゃんに戻ると、

頭がいいとはIQが高いこととはサトウ先生は思っていないで、

「未知の環境に柔軟に適応できる能力」と考えてるとのことでした。

「未知の環境に柔軟に適応できる能力」と考えてるとのことでした。

芸人さんでは、爆笑問題の田中さんを挙げてました。

たしかに!頭の良さでは、太田さんより、田中さんですよね!

(そう、思わない人もいるかもしれないけど…)

たしかに!頭の良さでは、太田さんより、田中さんですよね!

(そう、思わない人もいるかもしれないけど…)

P.S

なお、原西さんのギャグがすべった理由もこれで説明付きますね!

ギャグは、

・類推で考えたら、それが成り立つけど

・論理的に考えたら違う(ないしは意外にもなりたつ)という事柄で

・みんなが気付く前に、相方・ないしは自分がツッコんで、明確にする

ことにより、発生するものだと思うと前に書きました

初めの「みみくそもここにいれたらはなくそ」は、

はなに持って行った時点でわかることと、

意外性もあんまりないので、おもしろくない

二つ目の「うーは」は、

歯に手をやっても、だからなに・・・で終わってしまって

理解した・・・で?で意外性もなにもないので、面白くない

最後の「全体なまれ」は、滑れという指示なのにみんな笑ってたのは

「全体とまれ」なのに「なまれ」でここの意外性に注意していたところに

1,2が本当になまっていて、そのギャップがあり得るギャップだったので

おもしろく感じてしまったんだと思います。

ギャグは、

・類推で考えたら、それが成り立つけど

・論理的に考えたら違う(ないしは意外にもなりたつ)という事柄で

・みんなが気付く前に、相方・ないしは自分がツッコんで、明確にする

ことにより、発生するものだと思うと前に書きました

初めの「みみくそもここにいれたらはなくそ」は、

はなに持って行った時点でわかることと、

意外性もあんまりないので、おもしろくない

二つ目の「うーは」は、

歯に手をやっても、だからなに・・・で終わってしまって

理解した・・・で?で意外性もなにもないので、面白くない

最後の「全体なまれ」は、滑れという指示なのにみんな笑ってたのは

「全体とまれ」なのに「なまれ」でここの意外性に注意していたところに

1,2が本当になまっていて、そのギャップがあり得るギャップだったので

おもしろく感じてしまったんだと思います。

P.P.S それと、

「月に足跡を残した6人の少女達は一体何を見たのか」

っていうグループは、こんな歌を歌っているみたい。

MusicVideo【月に足跡を残した6人の少女達は一体何を見たのか...(ツキアト)】「静寂BROKEN」

原西さんがメンバーとグループ名を覚えるのに挑戦してたけど、

メンバー6人+グループ名で7つのことを覚えなければいけないので、

ふつう覚えられない(マジックナンバー7なので、7つ覚えるのが限界

だけど、この能力は年齢によって下がるので、原西さんの年齢なら

覚えられないほうが当然)のに、

近いところまでいっただけでも、スゴイと思います。

ぜんぜんワーキングメモリ苦手じゃないです。

わたしなんか、グループ名すら覚えられませんでした。

ふつう覚えられない(マジックナンバー7なので、7つ覚えるのが限界

だけど、この能力は年齢によって下がるので、原西さんの年齢なら

覚えられないほうが当然)のに、

近いところまでいっただけでも、スゴイと思います。

ぜんぜんワーキングメモリ苦手じゃないです。

わたしなんか、グループ名すら覚えられませんでした。

AIで書いた絵に対して、まるで、コロナのころのマスク警察のように、なんやかんや言ってくるAI警察の人たちが、急上昇中らしい

【悲劇】反AIの魔女狩りで絵師たちが地獄【画像生成AI問題】

たしかにすっげい時間かけた描いたうまい絵をAIって決めつけてコメントする人たちは、何なんだって感じだよね。

そのうち、ChatGPT警察も出てくると思います。

によると、(太字は上記記事より引用)

AIのリスクを四つに分類する。音声ガイドで未成年者を危険行為に誘導するなど容認できないケースは禁止し、AI対応のビデオゲームなど最小のリスクに該当する場合は任意の行動規範にとどめる。一般に流通するAIが対象で、研究・開発段階は対象外とした。

とのことらしいけど、Stable DiffusionのAIリスクはどのレベルになるんでしょうか?パンツ丸見え画像が生成出来るとかいうのは、容認できないレベルになってしまうんでしょうか?

・・・パンツ丸見え画像生成は趣味ではなくて研究ですといえば、OK?

いくら一流のシェフがやっているからと言って、

フランス料理店に行って、「ラーメン出せ」というのは、

客のほうが気がくるってる。

生成AIは、仕組み(本質的に)上、今までのコンピューターとは違い、

事実を正確に伝えない反面、

クリエイティブなものを作り出す能力を持っている。

つまり、フィクションを生成するための道具である。

どういうことかというと、ChatCPTなど、現在の生成AIは、

(その前の時代の生成AIであるGANとは異なり)

Transformer(トランスフォーマー:ChatGPTのTの意味)を

もとに作っている。

Transformerについては、

という論文が有名なんだけど、そこにあるように、

TransformerはAttentionが基になっていて、Attentionは上の論文

にあるように(↓の式は、その論文の4ページから引用)

っていう式であらわされる。

Qが検索対象

Kが、(Javaのハッシュマップ等)キーバリューストアで有名な、キー

Vが、キーバリューストアのV

一般のデータベース、あるいはGoogleなどの検索システムは、

Qの検索対象と、Kのキーが一致した時に、値Vを変えす

Qの検索対象と、Kのキーが不一致のときには、わからないとする

(検索失敗になる)

ところが、Attentionは、

まず、QとKの内積を求める

(Kの肩にTがかかっているのは、KもQもベクトルなので、このまま

だと掛け算できないためKのほうを転置行列にする。その転置のT)

→内積をとると、QとKの長さ*Cos「類似度」がでる。

このCosは、Cos類似度と呼ばれ、QとKの類似度になる

・・・あ~詳しくは、高校の数学の教科書見てくれ

・その類似度に基づいて、Vを返す

その結果

Qの検索対象と、Kのキーが一致した時に、値Vを変えす

Qの検索対象と、Kのキーが不一致のときには、

Qの検索対象と、Kのキーが不一致のときには、

QとKの類似度に応じて、Vの値を割り引いて返す※

具体例でいうと、

鎌倉幕府は1200年ごろできました

徳川幕府は1600年ごろできました

室町幕府は鎌倉幕府と徳川幕府の間にできました

室町幕府は何年にできたでしょう?

と聞かれると、

DB検索では、室町幕府の年号は入っていないので

→わかりません。

と答えるが、

ChatGPTなどのトランスフォーマーを使った場合、

鎌倉幕府が1200年で、徳川幕府は1600年で、その間なら

→1400年?

とか、値を「返してしまう」わかってないのに・・・

(実際は1330年ごろだから、間違い?)

この、教えてないけど、類似度に応じて値を返すという仕組みは、

事実を知りたい場合には、(適当に値を返されるから)困るけど

→上の例では室町幕府の成立を1400年って返されると、

受験的にはXです。

類似いたことを返してくれるってことは、連想してくれたりすることな

わけで、創造的、クリエイティブな仕事にはいいわけです。

たとえば、「足利尊氏の幼少期の物語を作りなさい」と言ったとき、

DBのように「そんなものは、登録されてないのでわからないです」

と言われたら、事実以外、なにも生まれませんが・・・

「足利尊氏」→「将軍」ってことで、源頼朝や徳川家康、その他

将軍の登録されている物語から、適当に割り引いて、乱数入れて

話ランダムに広げてくれれば、小説できるわけです。

小説は、それでいいんです。フィクションですから。

でも、うそじゃない。足利尊氏が源頼朝と同じだったらというフィクション

が入っているけど、そのレベルで大体こんなもんっていうのが

入ってきている。

つまり、生成AIはTransformerを使っている時点で、

正確なものではないけど、クリエイティブなことができるツール

っていうものになっているわけ。

クリエイティブというのは、フィクションが入ってくることであり、

フィクションは当然、事実ではない情報を含みます。

だから、ChatGPTは、「生成AIです」(=フィクションを含みます)

って言っているのに、それに対して、

「偽情報だあ」といって、マスコミがいじめるのも・・・なんだよねえ・・

自分たちは、ドラマとか流した時に

「このドラマはふくしょんであり」とかいって、「偽情報です」とは

言っていないんだよ・・・不公平だよねえ。

ちゃんと「 バック・トゥ・ザ・フューチャー 」とかに対して、

「現代ではタイムマシンはまだ完成しておらず、物理学的にも無理であり、

この映画は偽情報を含みます」って、言うべきになるけど・・・

・・・世の中の人は、そんなの求めてる???

なんか、マスコミが生成AIを「フィクション製造機です」と言わずに

「偽情報製造機」にみたいにディするのは、悪意があるのはもちろんだけど

(取材すれば、中身Transformerってことはすぐわかるし、Transformerは

上記のようなフィクション生成に長けていること、事実を検索する場合

にはDBを利用し、システムが違うことは、普通の学者は説明するはず)

最近、これ、スポンサーに関係してるんじゃないかと思っている。

つまり、「生成系AIはなんでもできる」と言って売りつけたいスポンサーと

いままでシステムを売ってきて、そういわれると困るスポンサー(はディするわけ)がいて、それらにご機嫌を取るから・・・本当のことは言えない。

本当のことは、クリエイティブな道具は、実は文章生成より、

画像生成のほうがお金になって、なので、アドビさんが目を

つけているっていうわけなんだけど・・・

・・・この続きは、また今度ね!

Attentionは、この検索対象、キー

Adobe先生(Adobe Sensei:AdobeのAI技術の総称)は、生成AI技術に

手を出してきたわけだけど・・・

Adobeの画像生成AI「Firefly - ファイアフライ」ベータ版使ってみた!

とうとう、その技術がPhotoshopにも使われ・・・

っていうか、もうPhotoshopのベータ版で使えるみたいですね。

↓の動画

【Adobe × 画像生成AI】Photoshopの最新機能がヤバい。『Adobe Fire』も一般公開スタート!

をだすまでもなく、皆さんもYouTube広告で、さんざん見てるよね!

人が消えたり、風景が延ばされたりするの・・・

生成AIの覇者はGAFAMでもなく、OpenAIでもなく、

Adobeで決まり!となりそうですな・・・

でも、デザイナーさん、(受難ではなく)呪文の時代の始まりですかね?

っていって、意味が通じないデザイナーさんは・・・

中国で「画像生成AI」急速な普及の影で…失職するイラストレーター急増 著作権侵害などの社会問題も|TBS NEWS DIG

なんていうふうに、淘汰されてしまうんでしょうね。

デザイナーさんのリスキリングが必要ですね!

必須スキル:呪文

・・・楽しそう(^^)v