Enterprise Linux Alternatives: Beyond Red Hat

Red Hat Enterprise Linux(RHEL)に代わるエンタープライズ向けLinuxの選択肢を整理しました。

2023年以降、Red Hat社によるソースコード公開方針の変更をきっかけに、多くのユーザーが代替ディストリビューションを模索するようになりました。ここでは主要なRHEL互換ディストリと、SUSEのような独立系エンタープライズLinuxの立ち位置を明確にします。

【RHEL互換ディストリと商用サポートのある選択肢】

Oracle Linux

・100%RHEL互換の商用ディストリビューション(Unbreakable Linux Kernelを選択可能)

・Oracle社から有償サポートあり

・Oracle Cloud Infrastructureとの親和性が高い

・100%RHEL互換の商用ディストリビューション(Unbreakable Linux Kernelを選択可能)

・Oracle社から有償サポートあり

・Oracle Cloud Infrastructureとの親和性が高い

SUSE Linux Enterprise Server(SLES)

・RHELとは互換性のない独立したLinux系ディストリビューション

・独自のパッケージ管理ツールZypper、設定ツールYaSTを採用

・Btrfsを標準ファイルシステムとし、スナップショット機能に強み

・SAPなどミッションクリティカルな用途に定評がある

・RHELとは互換性のない独立したLinux系ディストリビューション

・独自のパッケージ管理ツールZypper、設定ツールYaSTを採用

・Btrfsを標準ファイルシステムとし、スナップショット機能に強み

・SAPなどミッションクリティカルな用途に定評がある

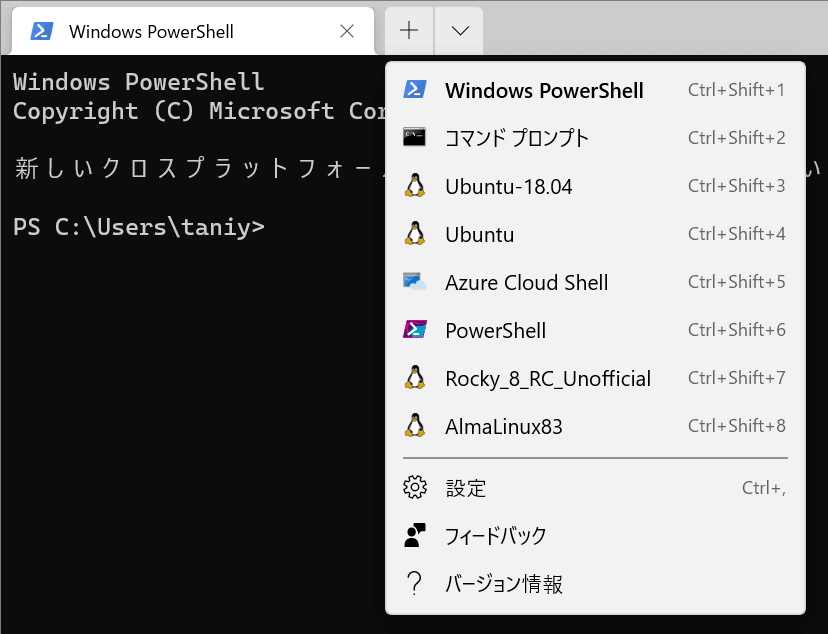

Rocky Linux

・CentOSの精神的後継として誕生したRHELクローン

・100%RHEL互換で、CIQなどからの商用サポートが可能

・OpenELAによるソースの安定供給を受けて開発継続中

・CentOSの精神的後継として誕生したRHELクローン

・100%RHEL互換で、CIQなどからの商用サポートが可能

・OpenELAによるソースの安定供給を受けて開発継続中

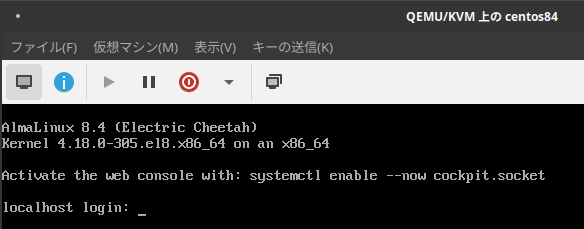

AlmaLinux

・CloudLinuxが支援するRHEL互換ディストリビューション

・中立的な非営利財団AlmaLinux OS Foundationにより運営

・RHEL互換のソースコードはAlmaLinux OS Foundation自身が収集・管理し、独自の方法で再構成。OpenELAには参加せず

・CloudLinuxが支援するRHEL互換ディストリビューション

・中立的な非営利財団AlmaLinux OS Foundationにより運営

・RHEL互換のソースコードはAlmaLinux OS Foundation自身が収集・管理し、独自の方法で再構成。OpenELAには参加せず

【よくある誤解の整理】

「Oracle LinuxはOracle製品専用」

→ 実際には一般用途にも使える完全なRHEL互換ディストリです。

→ 実際には一般用途にも使える完全なRHEL互換ディストリです。

「SUSEはRHEL互換ではないのか?」

→ SLESはRHELとは別系統のディストリです。互換性はなく、openSUSE系をベースとしています。

→ SLESはRHELとは別系統のディストリです。互換性はなく、openSUSE系をベースとしています。

「Rockyはコミュニティ専用」

→ 商用サポートが存在し、法人利用も十分に可能です。

→ 商用サポートが存在し、法人利用も十分に可能です。

「AlmaLinuxはCloudLinuxのプロダクト」

→ AlmaLinuxはCloudLinux社から独立した非営利財団によって管理されています。

→ AlmaLinuxはCloudLinux社から独立した非営利財団によって管理されています。

「RHEL互換ディストリは互換性トラブルを起こす」

→ OpenELAにより安定したソース供給が保証され、以前のCentOSよりも高い透明性が確保されています。

→ OpenELAにより安定したソース供給が保証され、以前のCentOSよりも高い透明性が確保されています。

【OpenELAについて】

OpenELA(Open Enterprise Linux Association)は2023年にSUSE、CIQ(Rocky Linux)、Oracleによって設立された非営利の共同体です。

目的は、RHEL互換ディストリに対して継続的に利用可能なソースコードを提供し、開発やビルドの透明性を維持することです。これにより、今後も安心してRockyやAlmaといった互換ディストリを利用できるようになります。

【結論】

RHELを取り巻く環境は大きく変化しましたが、現在はRocky Linux、AlmaLinux、Oracle LinuxといったRHEL互換OSに加え、SUSE Linux Enterprise Serverのような独立系ディストリビューションも確立された選択肢となっています。どのディストリを選ぶかは、求める互換性のレベル、商用サポートの可否、クラウドや業務システムとの親和性といった要件に応じて、慎重に検討すべき段階に入っています。

RHELを取り巻く環境は大きく変化しましたが、現在はRocky Linux、AlmaLinux、Oracle LinuxといったRHEL互換OSに加え、SUSE Linux Enterprise Serverのような独立系ディストリビューションも確立された選択肢となっています。どのディストリを選ぶかは、求める互換性のレベル、商用サポートの可否、クラウドや業務システムとの親和性といった要件に応じて、慎重に検討すべき段階に入っています。