© atomixmedia,inc 提供

まずは、こちらを...

*「差別するAI」は無知なだけ? 批判より啓蒙を...

情報テクノロジーの飛躍的な革新は、情報を通じて世界を一つにし、価値観を異にする多様な文化圏相互の対立や葛藤を克服し、わたしたちが生きる日常的な生活圏においても社会的、経済的な格差を縮めて行くはずだ...

そんな主張を耳にしたこともありましたが、残念ながら、そうなってはくれそうもありません。

人間ではなく、AIが応対しているにもかかわらず、人種やジェンダーによって対応が変わってしまう...そしてその対応の違いは、社会的な「差別的振る舞い」としてわたしたちには受け止められる。

このコラムでは、ニコンのカメラが、他の人種に較べて比較的眼が小さい東洋人の顔を「目を瞑っている」と認識して警告を発してしまう...特定の人種的・文化的特徴を備えた写真や単語に関連付けられるワードが肯定的、あるいは否定的な偏向を帯びていると認識される...といった例が出されています。

上の記事は、こうしたことに対して、AIが性差別・人種差別をしているのだと、AIが悪者にされている、という社会現象を紹介しているのですが、それは感情的には理解出来なくはないものの、あまりにも単純すぎる話です。

このコラムが紹介しているもとの記事は雑誌『ネイチャー』だといいますが、『ネイチャー』の論調が、コラムによる紹介通り「人工知能(AI)による性差別や人種差別が深刻な社会問題となっている」というものであるならば、自分自身の意志を持ち、自分自身の好悪によって態度を表明しているわけではなく、単純に人間によって設計されたアルゴリズムに従って情報を「処理」し、コマンドを実行しているだけのAIに、「差別主義的」であると汚名を着せるのは、いうまででもなくAIに対する、そのような世論の側の無知によるものです。

ただ、コラムが指摘しているように、AIには罪がない、と言うだけではもちろん、問題の解決にはなりません。

そもそも、どうしてこのような事態が起きるのか...そこが問題です。

そしてその点に関しては、このコラムは、AIに与えられているアルゴリズム処理のためのデータの偏りに、問題の根本を見ています。つまりAIそのものが人種差別的・性差別的であるかどうかではなく、AIがさまざまな判断をする際に参照する、判断のためのデータベースをどう作り上げていくかという問題、「学習データの構成問題」が決定的なのだ、というのです。

コラムは、スタンフォード大学がインターネットから収集した画像データのデータベースを分析し、

写真認識AIの開発に頻繁に使われるデータの約60%が、わずか3カ国から提供されているということだ。一方、世界人口の約36%を占める中国・インドからアップロードされている割合は3%だ...

と指摘する『ネーチャー』の記事を引用しています。ちなみに、引用文中の「わずか三ヵ国」というのは、アメリカ(45.4%)、イギリス(7.6%)、イタリア(6.2%)だといいます。

『ネイチャー』の記事ではまた、「ウィキペディア作成に参加している女性割合が、18%にも満たない」ということも指摘されているといいますが、これでは辞書の項目の採用や記事の詳細さ、学説紹介のバランス、内容...さまざまな偏りが色濃く生じることは容易に想像されます。

このウィキペディアについての指摘は、AIとは直接はかかわらないように思われるかも知れませんが、そうではありません。これは、AIが差別的な判断をしないための「公平で偏りのない」学習データベースなるものを作成することの難しさを指摘しています。

ネット上には性差別的・人種差別的なものだけではなく、政治的、宗教的、経済的、文化的な差別を助長するバイアスを強烈に帯びた情報が氾濫していますが、そうしたものから距離を取り、広く公開され、比較的公正に纏められ、幅広く利用されているウィキペディアに潜む問題点を指摘することで、既に強固に存在する社会全体における情報の偏りを考えるならば、AIに与えるべき「公平で偏りのない」学習データなど、一体どこにあるのか、どこから、どう取ってこれば良いのか...という問題提起となっています。

ネットの情報空間は、膨大な量の情報が氾濫するゆえに、あたかも情報の偏りが中和されているように「見える」だけであって、そもそもインター・ネットの情報空間にエントリーし、アクセスする人たちは特定の人たちであり、頻繁に発信し、その発信が影響力を持つゆえに反響を通じて再発信され、再々発信されるような人たちの存在を考えるならば、ネットの情報空間こそまさしく多数派をめぐる熾烈な闘争の場であり、常に強烈なバイアスの下で動いている世界であり、性的、人種的、文化的、政治的、経済的な公平さとはほど遠いのだ、ということを、わたしたちははっきりと意識しておかなければなりません。

広く門戸が開かれ、世界中の人がアクセス出来る、ということは、公平性やバランスを保証してくれはしません。情報空間におけるマジョリティーは経済的にも政治的にも強大な権力となりますから、むしろ反対に、情報空間は最も過激な権力闘争の場となっています。そのような場所から、公平公正、偏りのない...ということが果たして可能なのか...

さて、このコラムでは、「差別するAI」の問題を、

これら問題の大半は、差別というよりも「データ不足」もしくは「技術不足」、または「ネット&特定サービスに接続している人々の偏り」に原因があるとする観点の方が正しいはずである。人間で言えば「無知」で「世間知らず」なだけである・・・

と人間のアナロジーで纏めています。だから結論は、

必要なのは批判よりも、啓蒙である。差別偏向を正すためのデータをいかに広範かつ大量に収集できるか。新しいアイデアが求められそうだ・・・・・

と同じく人間の教育のアナロジーで締めくくられています。

これは、ある意味ではとてもよくわかることです。

AIは人間が設計したものであり、設計した人間を鏡のように映し出しています。

しかし、そこには人間の自画像が映ってはいるものの、それは映り出された姿にすぎないものであって、人間そのものではありません。

だから、アナロジーは所詮アナロジーであって、あたかも人間であるかのような結論を持ち込むことは、何の主張にもならないのです。

コラムでは、「差別するAI」の問題の解決を「啓蒙」という言葉で表現していますが、われわれ人間にとって「啓蒙」とはどういうことなのか...

たとえば、18世紀に開かれた「啓蒙の時代」のただ中に立ち、近代的なものの考え方の礎となる思想を鍛え上げたドイツの哲学者、イマヌエル・カントは『啓蒙とは何か』(1784年)のなかで、「啓蒙」とは「未成年の状態から抜け出ること」だと定義しています。そして「未成年の状態」とは「他人の指示を仰がなければ自分の理性を使うことができない」ことであると説明しています。それはたとえば、「書物に頼り」「牧師に頼り」「医者に食事療法を処方してもらう」...「お金さえ払えば、考える必要などない。考えるという面倒な仕事は、他人がひきうけてくれる」のだと、200年以上前にカントは言っています。

AIはインプットされる情報の処理を、人間によって設計されたアルゴリズムにしたがって「実行」します。ですから、AIの判断の論理的モデルは、設計者によってデザインされたものであって、デザインされたプロセスの指示にしたがって判定をしているだけです。だから、条件が同じであれば、基本的には同じ判断が導き出されるはずです。人間で言えば、20歳代の四季の移り変わり、30歳代の四季の移り変わり...家族とともに過ごす賑やかな四季の移り変わり...老境に入り、すべてを喪ってただ独り孤独に自分自身の生命の終わりを凝視しながらの四季の移り変わり...その時その時、人間の思考はさまざまな感懐とともに変化していきますが、AIにはそういうことがあるのでしょうか...

もしも人間の行う思考が...たとえば是非善悪、意味、価値といったものが、そして喜びや悲しみ、愛や憎しみ、怒り、赦し...パッションとわたしたちが呼んでいるさまざまなものが、数量化され、数学的に記述されるのであれば、人間とAIの間の差は、限りなく縮まることになるでしょう。

しかし、もしもそうでないのであれば、AIにインストールされる「思考」は、どのような論理によって構築されているにせよ、あらかじめ設計された制度の枠内における合理性の枠組みからでることはありませんし、命令の実行者ではあっても、命令の決断者ではありません。決断とは、さまざまな論理的枠組み...得失是非、善悪邪正...あるいは非合理的なパッションを伴った論理...義理人情、名誉、矜恃...の対立葛藤を断ち切って為す行為を指すのであって、初めからさまざまな対立軸の間にプライオリティーを設定しておいて、スムーズに論理的な決定を行うようにプログラムされているとすれば、それは「決断」ではなく、「実行」あるいは「遂行」でしかありません。

誰もが自分自身の中にさまざまな判断軸の間のプライオリティーを潜在的に持っていますが、それでも迷う。迷うのが、人間なのです。論理的には解決がつくようなことであっても、迷う。

それが人間の思考に特徴的なものであって、迷った上での決断は、どのようにして最終的にそのように決定したのか、表面的にはともかく、合理的な説明はできないものなのです。

そうした、非合理的で個人性を強く帯びた人間的な思考では困ることがあるから、AIに客観的で公平中立な、偏りのない判断を委ねる...なぜ「困る」かと言えば、わたしたちの社会は誰もが平等・公平に扱われるべきであるから...

上のコラムの結論「差別偏向を正すためのデータ」が必要だ、というのは、とても人間的な主張...それも、誰もが平等・公正に扱われるべきである、という現代の社会に生きる人間の主張です。その主張はとても人間的な強い願望を背景にしています。誰もが均質等価で、公平平等に扱われるべきだ...というのです。

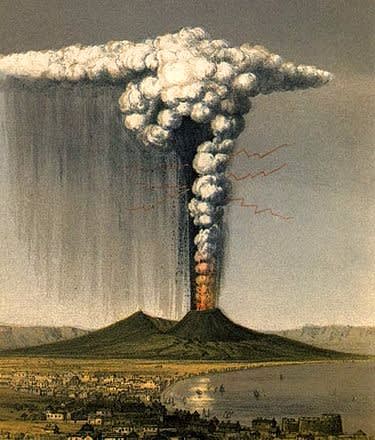

もちろん、それを悪いと言っているのではありません。しかし、自然界を見れば、どの生物も平等・公平に扱われたりはしていません。いつどこで河川が氾濫し、いつどこに熱波が襲い、いつどこで地震が起き、いつどこに寒波が襲うのか、誰もわかりませんし、誰もが襲われうる、という点では平等・公平でも、わたしたち一人一人が現実にそうしたものに見舞われるときには、簡単に納得などできません。当事者にとっては、いかなる平等も公平もありません。

結局、AIをめぐる様々な議論は、わたしたちが自分たちをどう考えるか、人間をどう考えるか、自分たちの生命を、人生をどう考えるか、という問題に帰着します。

だから、AIが差別するのではなく、差別するわたしたちの社会をAIが忠実に映し出しているだけなのです。

コラムでは、AIの学習データの偏向の問題を指摘していますが、偏向なくものを考える、ということはどういうことなのか...ここのところをきちんと考えるならば、社会的な正義と公正についての議論がどれほど紛糾し、出口の見えない議論に到るのか、『ジャスティス』をはじめとするマイケル・サンデルの一連の著作と、サンデルによって提出され、それをきっかけとして湧き上がってきたさまざまな議論を見ればわかるはずです。

AIの学習データベースを作成するときに、偏向を除去すると言うとき、一体誰がそれをするのか...

偏向なく公平・平等に情報を収集してデータベースを作成出来るような人が、ほんとうに存在するのでしょうか?

そしてそうした作業をAIにさせようとするのであれば、AIにその手続きを命令するプログラムは、誰が作るのか...プログラムそのものの問題もありますし、情報を取ってくるインターネットの情報空間そのものが抱え持っている強力な情報バイアスの問題も存在します。

現在のインターネットの情報空間にエントリーしている人々の人数と、その人たちの発信量は、世界中のすべての人の人口構成比を反映してはいません。そして、世界中のすべての人が、同じ比重で扱われるような形で、インターネットの情報空間にエントリーする時代がいつかやってくる、等と本気で信じるような人はいないと思います。もしもそのようなことが起きるとするならば、それは同時に裏側から見れば、ネットによる世界的規模での監視社会の誕生にほかなりませんし、ネット空間における巨大パノプティコンの誕生であって、世界はオーウェルが予言したような究極のディストピアになってしまいかねません。

ほんとうに必要なのは、AIの啓蒙ではなく、啓蒙とはどういうことなのか、考えるとはどういうことなのか、とわたしたち自身が考えることです。その意味では、カントの提出した課題にたいして、わたしたちはまだまったく応えることができていません。

そして、公平を期すために言えば、AIの研究は、わたしたちの行う「思考」というものを、伝統的な「内省」という方法とは正反対の側面から明らかにしてくれるものであり、その意味では、AIテクノロジーの発展は、哲学的に極めて興味深いテーマを数多くもたらしてくれるものでもあるのです。

AIテクノロジーは限りなく人間の思考に近づいていきますが、それはもう一方で、人間がものを考えるということはいったいどういうことなのか、それを理解していく作業にほかなりません。ただ、忘れてはならないことは、AIの機能が飛躍的に向上することによって、いつしか人間がものを考えることは、すなわちアルゴリズムの処理なのだ、と思い込んでしまうことです。

人間の思考にも、アルゴリズムの処理と重なり合うような側面を見ることは可能です。しかし、鏡に映っている自分を自分自身だと思い込むのと同じ、一種の錯誤でしかありません。

便利さのために、自分自身を放棄する...

考えることの放棄は、究極の隷属状態です。その時、自分は人間として何のために生きているのか、どう生きていきたいのか、それを忘れてしまう本末の転倒が起きる...

AIをめぐる様々な議論の中にそうした転倒の萌芽を見出すたびに、私は言い知れぬ思いを抱くのです。