引き続きRLC並列回路図を描くJavascriptソースコードを書いてもらったが、これはうまくいかなかった。

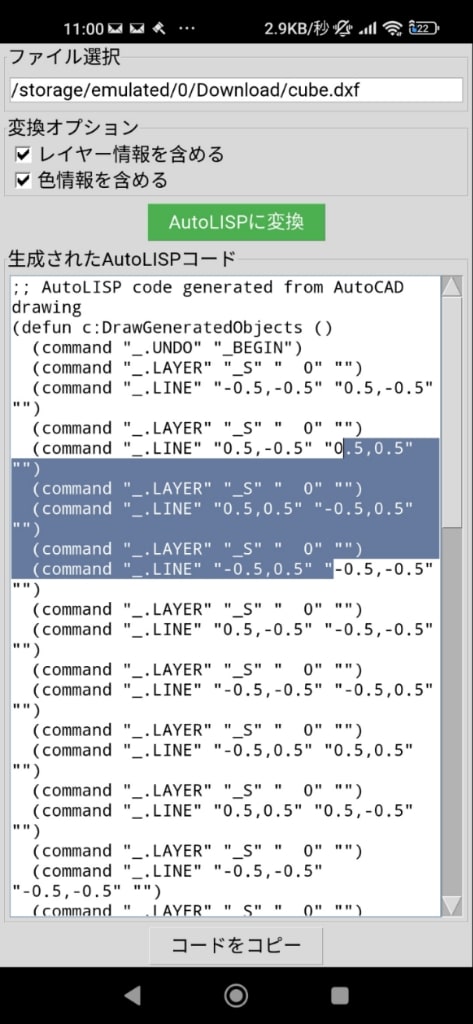

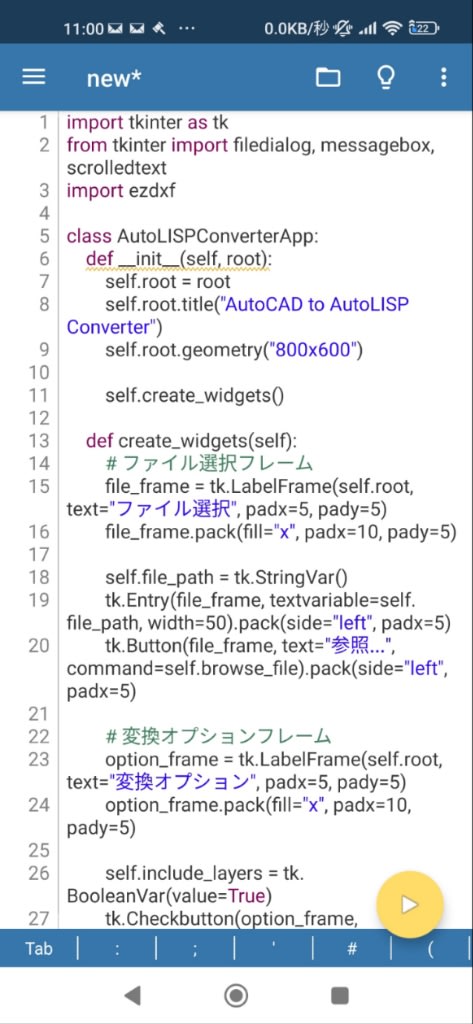

DXFファイルからAutoLispプログラムに変換成功!!! #gooblog https://blog.goo.ne.jp/nichikon2/e/87502773182547883e0c09c4d0b0f3e3

# YouTube音楽を楽譜に変換するアドオン

YouTubeの動画から音楽を解析して楽譜(スコア)を生成するアドオンのソースコードを作成します。このアドオンはWeb Audio APIと音楽解析ライブラリを使用して実装できます。

## 必要な技術要素

1. Web Audio API - 音声データの取得と解析

2. WebExtension API - Chrome拡張機能としての機能

3. Music21.jsまたはTone.js - 音楽解析と楽譜生成

4. VexFlow - 楽譜の表示

## 実装コード

以下はChrome拡張機能として実装する場合の主要なコードです。

### manifest.json

```json

{

"manifest_version": 3,

"name": "YouTube Music to Score",

"version": "1.0",

"description": "YouTubeの音楽を楽譜に変換します",

"permissions": [

"activeTab",

"scripting"

],

"host_permissions": [

"*://*.youtube.com/*"

],

"background": {

"service_worker": "background.js"

},

"action": {

"default_popup": "popup.html",

"default_icon": {

"16": "images/icon16.png",

"48": "images/icon48.png",

"128": "images/icon128.png"

}

},

"content_scripts": [

{

"matches": ["*://*.youtube.com/*"],

"js": ["content.js"]

}

],

"web_accessible_resources": [{

"resources": ["script.js", "styles.css"],

"matches": ["*://*.youtube.com/*"]

}]

}

```

### content.js

```javascript

// YouTubeページにUIを追加

function addButtonToPage() {

const button = document.createElement('button');

button.id = 'transcribe-music';

button.textContent = '楽譜に変換';

button.style.position = 'fixed';

button.style.bottom = '20px';

button.style.right = '20px';

button.style.zIndex = '9999';

button.style.padding = '10px 15px';

button.style.backgroundColor = '#ff0000';

button.style.color = 'white';

button.style.border = 'none';

button.style.borderRadius = '5px';

button.style.cursor = 'pointer';

button.addEventListener('click', startTranscription);

document.body.appendChild(button);

}

function startTranscription() {

// YouTubeのオーディオコンテキストにアクセス

const video = document.querySelector('video');

if (!video) {

alert('YouTubeの動画が見つかりません');

return;

}

// オーディオコンテキストの作成

const audioContext = new (window.AudioContext || window.webkitAudioContext)();

const source = audioContext.createMediaElementSource(video);

// アナライザーの設定

const analyser = audioContext.createAnalyser();

analyser.fftSize = 2048;

source.connect(analyser);

analyser.connect(audioContext.destination);

// 音声データの処理開始

processAudio(analyser, audioContext.sampleRate);

}

function processAudio(analyser, sampleRate) {

const bufferLength = analyser.frequencyBinCount;

const dataArray = new Uint8Array(bufferLength);

// 定期的に音声データを取得して解析

const intervalId = setInterval(() => {

analyser.getByteTimeDomainData(dataArray);

// ここで音高やリズムを解析

const notes = analyzePitch(dataArray, sampleRate);

// 解析結果を表示

displayNotes(notes);

}, 100);

// 10秒後に停止(実際はユーザー操作で停止させるべき)

setTimeout(() => {

clearInterval(intervalId);

}, 10000);

}

function analyzePitch(dataArray, sampleRate) {

// 簡易的なピッチ検出アルゴリズム(実際にはより高度なものを使用)

const notes = [];

// ゼロクロッシング法による基本周波数の検出

let zeroCrossings = 0;

for (let i = 1; i

if ((dataArray[i-1] < 128 && dataArray[i] >= 128) ||

(dataArray[i-1] >= 128 && dataArray[i]

zeroCrossings++;

}

}

const duration = dataArray.length / sampleRate;

const frequency = zeroCrossings / (2 * duration);

if (frequency > 0) {

// 周波数から音名に変換

const noteName = frequencyToNote(frequency);

notes.push({

frequency,

noteName,

duration: 0.5 // 仮の値

});

}

return notes;

}

function frequencyToNote(frequency) {

// 周波数から音名への変換

const A4 = 440;

const noteNames = ['C', 'C#', 'D', 'D#', 'E', 'F', 'F#', 'G', 'G#', 'A', 'A#', 'B'];

const n = Math.round(12 * Math.log2(frequency / A4)) + 57;

const octave = Math.floor(n / 12) - 1;

const noteIndex = n % 12;

return noteNames[noteIndex] + octave;

}

function displayNotes(notes) {

// 楽譜表示用のdivを作成

let scoreDiv = document.getElementById('music-score');

if (!scoreDiv) {

scoreDiv = document.createElement('div');

scoreDiv.id = 'music-score';

scoreDiv.style.position = 'fixed';

scoreDiv.style.top = '20px';

scoreDiv.style.right = '20px';

scoreDiv.style.width = '300px';

scoreDiv.style.height = '400px';

scoreDiv.style.backgroundColor = 'white';

scoreDiv.style.zIndex = '9999';

scoreDiv.style.padding = '10px';

scoreDiv.style.overflow = 'auto';

scoreDiv.style.boxShadow = '0 0 10px rgba(0,0,0,0.5)';

document.body.appendChild(scoreDiv);

}

// VexFlowを使用して楽譜を表示(簡易版)

notes.forEach(note => {

const noteElement = document.createElement('div');

noteElement.textContent = `${note.noteName} (${note.duration}拍)`;

noteElement.style.margin = '5px 0';

scoreDiv.appendChild(noteElement);

});

}

// YouTubeページが読み込まれたらボタンを追加

if (document.readyState === 'complete') {

addButtonToPage();

} else {

window.addEventListener('load', addButtonToPage);

}

```

### popup.html

```html

<!DOCTYPE html>

<html>

<head>

<title>YouTube Music Transcriber</title>

<style>

body {

width: 300px;

padding: 10px;

}

button {

background-color: #ff0000;

color: white;

border: none;

padding: 10px 15px;

border-radius: 5px;

cursor: pointer;

width: 100%;

}

.status {

margin-top: 10px;

padding: 10px;

border-radius: 5px;

}

.active {

background-color: #e6ffe6;

}

</style>

</head>

<body>

YouTube Music Transcriber

<button id="activate">楽譜変換を開始</button>

<script src="popup.js"></script>

</body>

</html>

```

### popup.js

```javascript

document.getElementById('activate').addEventListener('click', () => {

chrome.tabs.query({active: true, currentWindow: true}, (tabs) => {

chrome.scripting.executeScript({

target: {tabId: tabs[0].id},

function: startTranscriptionFromPopup

}, () => {

document.getElementById('status').textContent = '楽譜変換を開始しました';

document.getElementById('status').classList.add('active');

});

});

});

function startTranscriptionFromPopup() {

// content.jsの関数を呼び出す

if (typeof startTranscription === 'function') {

startTranscription();

}

}

```

## 高度な音楽解析の実装

上記のコードは簡易的な実装です。より正確な楽譜変換を行うには、以下のような高度なライブラリの統合が必要です。

### 音楽解析ライブラリの統合例

```javascript

// より高度な音楽解析を行う場合の例

async function advancedTranscription() {

try {

// TensorFlow.jsと音響モデルの読み込み

const tf = await import('https://cdn.jsdelivr.net/npm/@tensorflow/tfjs@3.18.0/dist/tf.min.js');

const model = await tf.loadGraphModel('https://example.com/music-transcription-model.json');

// 音声データの取得と前処理

const audioData = await getAudioData();

const inputTensor = tf.tensor(audioData).reshape([1, ...audioData.shape]);

// モデルによる推論

const prediction = model.predict(inputTensor);

const notes = postProcessPrediction(prediction);

// 楽譜の表示

renderScore(notes);

} catch (error) {

console.error('楽譜変換エラー:', error);

}

}

function renderScore(notes) {

// VexFlowを使用した本格的な楽譜表示

const div = document.createElement('div');

div.id = 'vexflow-score';

document.body.appendChild(div);

const renderer = new Vex.Flow.Renderer(div, Vex.Flow.Renderer.Backends.SVG);

const context = renderer.getContext();

const stave = new Vex.Flow.Stave(10, 10, 400);

stave.addClef("treble").addTimeSignature("4/4");

stave.setContext(context).draw();

const notesToDraw = notes.map(note => {

return new Vex.Flow.StaveNote({

keys: [note.pitch],

duration: note.duration

});

});

Vex.Flow.Formatter.FormatAndDraw(context, stave, notesToDraw);

}

```

## 注意点

1. **著作権の問題**: YouTubeの音楽を楽譜に変換する行為は著作権法に抵触する可能性があります。個人利用に限定するなどの配慮が必要です。

2. **技術的制約**: 完全に正確な楽譜変換は非常に難しく、特にポリフォニックな音楽(和音や複数の楽器)の解析は現在の技術でも困難です。

3. **パフォーマンス**: リアルタイムでの音楽解析はCPU負荷が高いため、効率的なアルゴリズムの選択が必要です。

4. **ブラウザの制限**: 最新のWeb Audio APIの機能を使用するためには、最新版のブラウザが必要です。

このコードは基本的なフレームワークを提供しますが、実際に使用するにはさらに開発と調整が必要です。特に音楽解析の部分は、専門的な信号処理アルゴリズムや機械学習モデルの統合が必要になるでしょう。