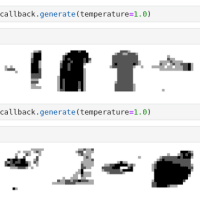

もはやAI実験機と化したサブPCで、RTX A2000を使ってサクッとStable Diffusionが動いたのは先日の記事の通りだが、その一方で RTX A2000のメモリが6GBしか無いという制限は厳に存在する。

ということで、24GB搭載のTesla K80 でも試してみることにした。

空冷ファンの都合上サブPCには収まらないのでメインPCで実験。一度、RTX A2000でcuda 12.0の環境にしてしまっていたので、K80に戻して動作確認するまでにドライバやcuda tool kitの再インストールとかで手間取ったが、あとはstable-diffusion-webui をインストールしてStable Diffusionがさくっと動いたが、...

1. K80をちゃんと冷やさないとcudaのエラーで止まる. やけに処理に時間がかかるな、と思ってshellの画面をみるとcudaのエラーで stable-diffusionが落ちているという事がある。

2. K80の半分しか使われていない。Tesla K80はソフトから見ると12GBのメモリを搭載した2台のGPUなのだが、そのうち1台しか利用されない。どうも、複数のGPUを束ねて利用する機能は無いようだ。その代わり、Stable Diffusionを二つ立ち上げて、それぞれが別のGPUを使うというやり方があるそうな。

3. 遅い. RTX A2000で4枚40秒だったのがTesla K80だと2分16秒. まあ、K80はTensor コアも半精度も無い古いアーキテクチャなので当然の結果と言えなくもないが。

という事で、Stable Diffusionについてはヤフオクなどで捨て値で手に入るTesla k80で楽しめなくもないが、冷却のためのあれやこれやを考えたらアクティブ冷却(=冷却ファン内蔵)のGPUを選んだ方が合理的だろうというのが私の結論。

1. K80をちゃんと冷やさないとcudaのエラーで止まる. やけに処理に時間がかかるな、と思ってshellの画面をみるとcudaのエラーで stable-diffusionが落ちているという事がある。

2. K80の半分しか使われていない。Tesla K80はソフトから見ると12GBのメモリを搭載した2台のGPUなのだが、そのうち1台しか利用されない。どうも、複数のGPUを束ねて利用する機能は無いようだ。その代わり、Stable Diffusionを二つ立ち上げて、それぞれが別のGPUを使うというやり方があるそうな。

3. 遅い. RTX A2000で4枚40秒だったのがTesla K80だと2分16秒. まあ、K80はTensor コアも半精度も無い古いアーキテクチャなので当然の結果と言えなくもないが。

という事で、Stable Diffusionについてはヤフオクなどで捨て値で手に入るTesla k80で楽しめなくもないが、冷却のためのあれやこれやを考えたらアクティブ冷却(=冷却ファン内蔵)のGPUを選んだ方が合理的だろうというのが私の結論。